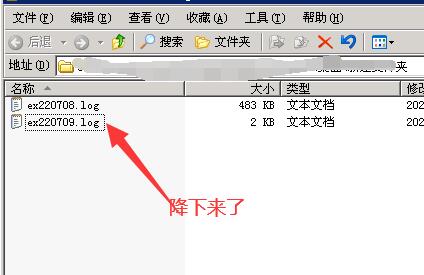

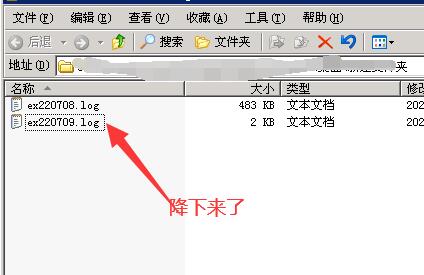

国外的蜘蛛是有多烦人?一天产生将近500K的访问日志,300个网站的服务器差不多要产生150M的日志。这个存储空间倒是不怕,因为用几百G的硬盘,也够了。只是大量的访问导致服务器内存受不了,无法创建新的线程,会卡顿异常。昨天封禁了一下国外的这种蜘蛛,又把虚拟内存调大,服务器卡顿的问题得以缓解。蜘蛛也由500K降下来了,预计今天不会超过10k,是很大的胜利。

把robots.txt文件贴出来,给需要的朋友们吧!

User-agent: MJ12bot

Disallow: /

User-agent: SemrushBot

Disallow: /

User-agent: SemrushBot-SA

Disallow: /

User-agent: SemrushBot-BA

Disallow: /

User-agent: SemrushBot-SI

Disallow: /

User-agent: SemrushBot-SWA

Disallow: /

User-agent: SemrushBot-CT

Disallow: /

User-agent: SemrushBot-BM

Disallow: /

User-agent: SemrushBot-SEOAB

Disallow: /

user-agent: AhrefsBot

Disallow: /

User-agent: DotBot

Disallow: /

User-agent: Uptimebot

Disallow: /

User-agent: MegaIndex.ru

Disallow: /

User-agent: ZoominfoBot

Disallow: /

User-agent: Mail.Ru

Disallow: /

User-agent: BLEXBot

Disallow: /

User-agent: ExtLinksBot

Disallow: /

User-agent: aiHitBot

Disallow: /

User-agent: Researchscan

Disallow: /

User-agent: DnyzBot

Disallow: /

User-agent: spbot

Disallow: /

User-agent: YandexBot

Disallow: /

User-agent: Barkrowler

Disallow: /

最后想说,网站提速是多方面的, 不是简单粗暴的从程序着手,也不是一味地就以为服务器配置低。要从原因上综合分析。例如这种爬虫导致服务器压力过大的情况,解决下来的可能是:

1、升级服务器

2、改造程序,让占用内存少一些

3、封禁不必要的搜索蜘蛛

4、拦截不正常的访问

具体是要结合网站程序情况,目前服务器的配置情况,客户能够接受的方式,进行综合性判断和解决的。

还没有人来评论,快来抢个沙发吧!